9. Datos no estructurados

9.1 Introducción

Colecciones no estructuradas

• Datos sin tipos pre-definidos

• Se almacenan como “documentos” u “objetos” sin estructura uniforme

• Se recuperan con apoyo de índices ymodelos de “RI” para determinar su relevancia respecto a consultas del usuario

• Ejemplos:

- Correspondencia, diarios, novelas, blogs

Recuperación de Información (RI)

• Area de las ciencias computacionales que estudia técnicas y métodos para indexar y consultar colecciones de diversos niveles de estructura

• Proceso para determinar los documentos relevantes para un tema especificado por el usuario

– Ejemplo:

“Encontrar documentos sobre historia de los juegos olímpicos”

– El problema involucra interpretar, comparar, jerarquizar,…

• Comparar con recuperación de datos:

– Obtención de todos los elementos en una colección que satisfacen totalmente condiciones claramente especificadas.

Ejemplo: Encontrar los nombres de todos los estudiantes de la

carrera de ISC

– El problema es sencillo si se cuenta con una base de datos relacional:

• select nombre from estudiantes where carrera = ‘IS’

RI cobra importancia

• Se inicia con tablas de contenido e índices de libros

• Las bibliotecas introdujeron índices a múltiples publicaciones, referencias cruzadas e índices jerárquicos para clasificar documentos

• Desde los 40s, se inicia RI orientado a indexar y recuperar textos pero la recuperación de datos domina

• En los 90s, el desarrollo de WWW hace de RI un área fundamental y acelera su evolución

• RI incluye ahora modelado, indexado, clasificación, interfaces de usuario, visualización de datos textuales, multimediales e hipertextuales

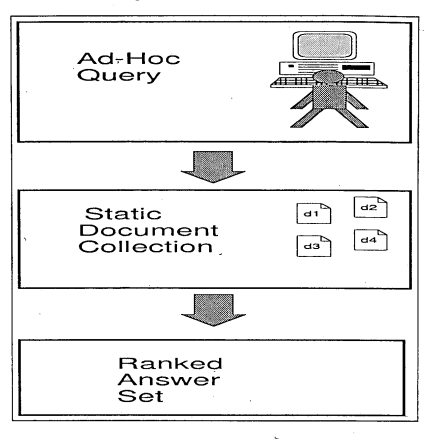

• Meta: Dada una consulta, obtener todos los documentos relevantes posibles y minimizar el número de documentos irrelevantes

|

El reto

• El enfoque inicial: clasificar documentos

• El problema: quien categoriza no coloca los documentos donde espera encontrarlos quien busca, a veces ni el mismo clasificador (ej. archivos personales, folders de correo electrónico)

• Otro enfoque: “entender” el contenido y responder a consultas

• Problema: El procesamiento de lenguaje natural aún no es lo suficientemente general (¿ni lo será?)

• La alternativa: RI, basada en reconocimiento de patrones, muestreo estadístico, aprendizaje maquinal, probabilidad,…

• La meta de RI: encontrar documentos relevantes rápidamente

• RI será un área de investigación mientras los métodos existentes no sean suficientemente efectivos y eficientes simultáneamente

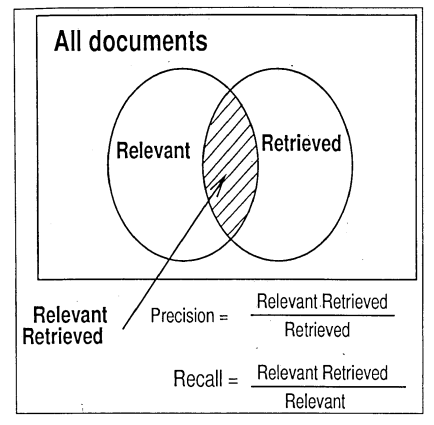

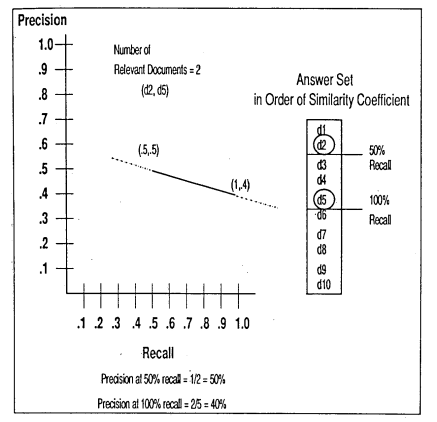

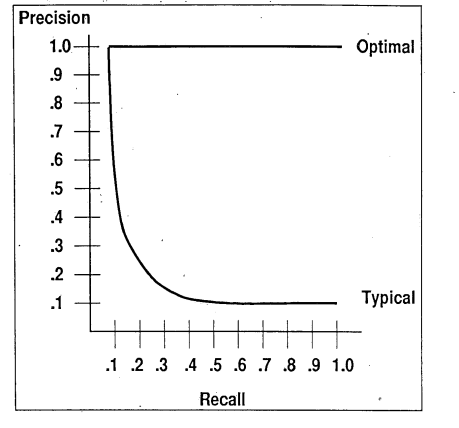

Medidas de efectividad de RI

• Precisión (o “especificidad”)

• Cobertura (o “exhaustividad”)

|

|

|

Visión Lógica de los Documentos

Es la representación de documentos y/o páginas web que forman parte de una colección (sistema de IR).Por otro lado para realizar el “stemming” (reducir palabras de su raíz gramatical) se emplea el algoritmo de Porter, solo que hay que tener en cuenta el idioma a utilizar ya que por lo general se encuentra en inglés aunque hay versiones para español. http://www.tartarus.org/~martin/PorterStemmer/

Existen 2 tipos de tareas principales en la recuperación de información:

- Las centradas en la computadora: consiste en construir un índice eficiente, procesar las consultas del usuario con un alto rendimiento y algoritmos (modelos de recuperación) que mejoren la calidad de respuesta del sistema.

- Las centradas en el humano: consiste principalmente en estudiar las necesidades del usuario, saber cómo afecta a la organización, operación y visualización de resultados en el sistema de recuperación.

9.2 Modelos de Recuperación

Modelos clásicos de RI

• Booleano, vectorial y probabilístico

• Diseñados para colecciones de texto

• El modelo lógico de los documentos consiste de “términos” o palabras que se refieren (indexan) al tema principal tratado

• Algunas propiedades útiles:

- Los términos que aparecen en casi todos los documentos no son útiles

- Algunos términos pueden tener mayor relevancia con respecto a un documento dado, lo que se puede denotar por un “peso” del término

- Para un término ki y un documento dj, wi,j >=0 denota la importancia del término para describir el contenido del documento

- Para una colección con t términos, puede definirse el vector Dj = (w1,j, w2,j,… wt,j)

9.2.1 Clasificación

9.2.2 Modelo Booleano

El modelo Boleano, es un modelo de recuperación simple basado en la teoría fija y álgebra de Boolean, este modelo proporciona un grupo de trabajo que es fácil de usar por un usuario común de un sistema de IR. Además, las llamadas se especifican como expresiones de Boolean que tienen la semántica precisa. Dado su simplicidad inherente y formalismo, el modelo de Boolean recibió la gran atención y se adoptó por muchos de los sistemas bibliográficos comerciales.De este modelo se pueden destacar los siguientes puntos:

- La relevancia es binaria: un documento es relevante o no lo es.

- Consultas de una palabra: un documento es relevante si contiene la palabra.

- Consultas AND: Los documentos deben contener todas las palabras.

- Consultas OR: Los documentos deben contener alguna palabra.

-

Consultas A BUTNOT B: Los documentos los documentos deben

ser relevantes para A pero no para B.

· Ejemplo: lo mejor de Maradona

Maradona AND Mundial

AND (( México ’86 OR Italia ’90) BUTNOT U.S.A. ’94) - Es el modelo mas primitivo, sin embargo es el mas popular.

¿Por qué es malo?

- No discrimina entre documentos más y menos relevantes.

- Da lo mismo que un documento contenga una o cien veces las palabras de consulta.

- Da lo mismo que cumpla una o todas las cláusulas de un OR.

- No permite ordenar los resultados.

-

Puede resultar confuso

Ejemplo: Necesito investigar sobre los Aztecas y los Incas

Aztecas AND Incas

(cuando en realidad lo que se pretendía era: Aztecas OR Incas).

¿Por qué es popular?

- Es una de los primeros modelos que se implemento y muchos de los primeros sistemas de IR se basaron en él

- La idea suele ser común entre los usuarios que la están usando.

- Es la opción favorita para insertar texto en un RDBMS.

- Es simple de formalizar y eficiente de implementar.

- En algunos caso (usuarios expertos) puede ser adecuado.

- Puede ser útil en combinación con otro modelo ej. Para excluir documentos.

-

Puede ser útil con buenas interfaces.

Tablas posibles para el modelo booleano

• Docs (IdDoc, NombreDoc, FechaPub, …, texto)

• IndiceInv (IdDoc, Term)

• Consulta (Term)

• Un pre-proceso puede producir Docs (extrayendo datos de archivos) e

IndiceInv (vía parser, lematización, eliminación de palabras vacías)

Uso de SQL para el modelo booleano

• Encontrar los ids de documentos que contengan los término “casa” o “blanca”

– select distinct IdDoc from IndiceInv

where term = ‘casa’ or term = ‘blanca’

• Recuperar el texto de los documentos…

– select texto from Docs

where IdDoc in

(select distinct IdDoc from IndiceInv

where term = ‘casa’ or term = ‘blanca’)

• ¿Cómo se obtendrían los documentos que contienen “casa” y “blanca”?

SQL para el modelo booleano

• “AND” usando agregación y agrupación:

– select IdDoc from IndiceInv i, Consulta q

where i.term = q.term

group by i.IdDoc

having count(i.term) = (select count(*) from Consulta)

• en este caso, “where” asegura que se incluyen los términos pedidos,

“group by” agrupa los términos para cada documento,

y “having” que haya tantos términos en el documento como en la consulta

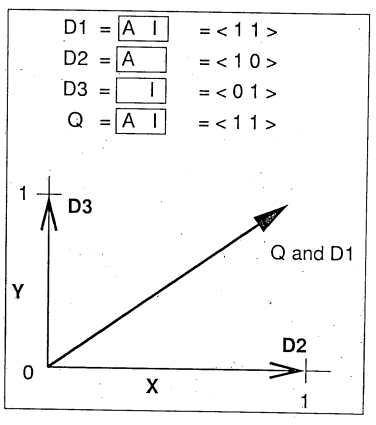

9.2.3 Modelo de Espacios Vectoriales

8.2.3.1 Introducción

• Propuesto en 1975, hoy el más popular (con variantes)

• También llamado solamente “modelo vectorial”

• Generaliza el modelo booleano al manejar pesos no binarios para los términos de cada documento y de la consulta (query)

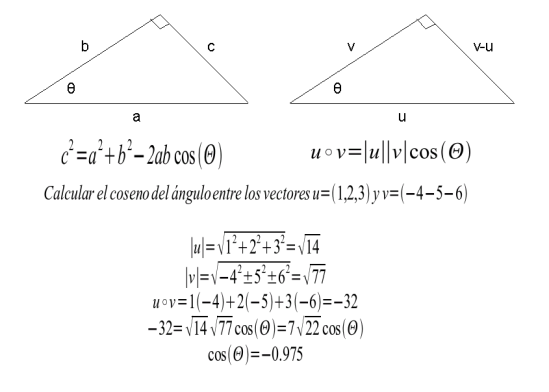

• Determina la similitud entre la consulta y cada documento calculando el ángulo entre sus vectores

• La idea principal es que dos documentos son similares si sus vectores apuntan hacia la misma dirección

• Un aspecto importante es la determinación del peso de cada término, típicamente basado en su frecuencia:

- el peso aumenta entre más ocurre en un documento dado

- el peso disminuye entre más aparece en los demás documentos

|

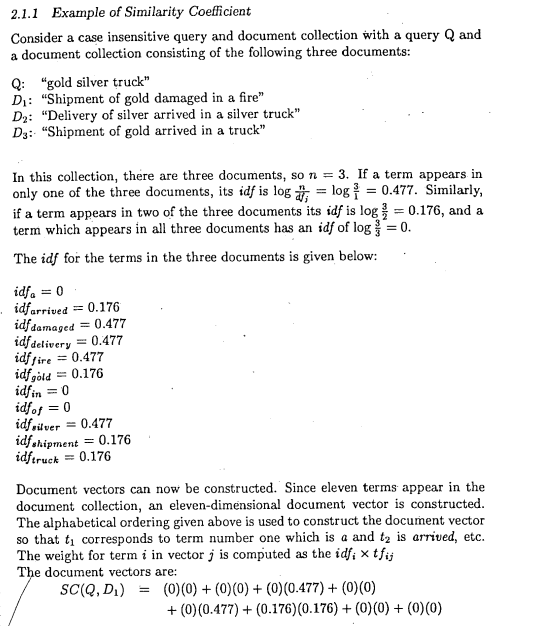

8.2.3.2 Algoritmo

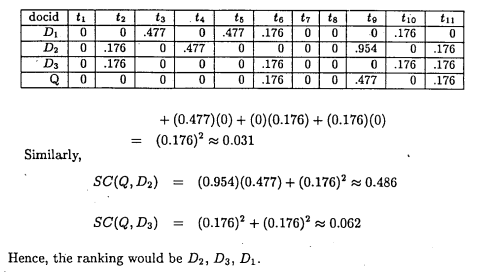

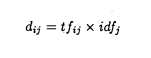

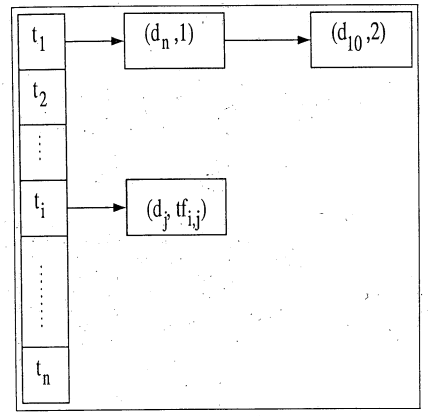

Uso de frecuencia inversa (TFIDF)

• Considerando

– n = número de términos distintos en una colección

– tfij = número de ocurrencias en el documento i del término tj

– dfj = número de documentos que contienen tj

– idfj = log(d/dfj) = frecuencia inversa de documentos, donde d es el número total de documentos

• entonces cada vector tiene n componentes

• para una gran colección de documentos pequeños, los vectores contendrán muchos ceros

• un cálculo del peso para el j-ésimo elemento del documento di es:

|

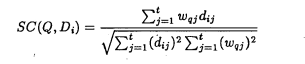

• la similitud entre una consulta Q y un documento Di puede definirse

como el producto de los dos vectores:

|

|

|

|

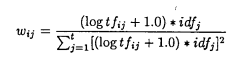

En 1988 Salton y Buckley proponen modificaciones a las medidas originales, sugiriendo la siguiente fórmula para el cálculo de pesos del término j en el documento i. Esta variación se debió al argumento de que un match de un término con una frecuencia muy alta puede distorcionar a los demás matches entre el query y el documento.

|

Similarity Measures

Para medir la similitud entre los vectores formados por el query y cada documento existen muchas formulas, siendo la del coseno la más popular, ya que de una manera simple calcula el ángulo entre ambos vectores.

|

Conceptos Iniciales:

Teoría de Vectores

Tablas posibles para el modelo vectorial

|

• Docs (IdDoc, NombreDoc, FechaPub, …, texto) • IndiceInv (IdDoc, Term, tf) • Terms (term, idf) • Consulta (term, tf) |

• Un pre-proceso puede producir Docs (extrayendo datos de archivos) e

IndiceInv (vía parser, lematización, eliminación de palabras vacías)

• Terms puede producirse mediante:

– insert into terms

select term, log(N/count(*))

from IndiceInv

group by term

• donde N es el número total de documentos y se conoce o se puede obtener previamente (select count(*) from Docs)

• Consulta es solamente una representación tabular de la petición del usuario para facilitar el cálculo del índice de similitud

SQL para espacios vectoriales usando TFIDF

|

• select i.IdDoc, sum(q.tf * t.idf * i.tf * t.idf) from consulta q, IndiceInv i, Terms t where q.term = t.term and i.term = t.term group by i.IdDoc order by 2 desc • “where” garantiza que se incluyen sólo terminos de la consulta, “order by”, que se ordenan según el coeficiente de similitud

|

Cálculo del coseno del ángulo

• Tablas intermedias:

|

– pesos_docs(IdDoc, peso) – peso_q(peso) |

• Generación de tablas intermedias:

|

– insert into pesos_docs select IdDoc, sqrt(sum(i.tf * t.idf * i.tf * t.idf)) from IndiceInv i, Terms t where i.term = t.term group by IdDoc

– insert into peso_q select sqrt(sum(q.tf * t.idf * q.tf * t.idf )) from consulta q, Terms t where q.term = t.term

|

Cálculo del coseno del ángulo

|

• select i.IdDoc, sum(q.tf * t.idf * i.tf * t.idf) / (dw.peso * qw.peso) from consulta q, IndiceInv i, terms t, pesos_docs dw, peso_q qw where q.term = t.term AND i.term = t.term AND i.IdDoc = dw.IdDoc group by i.IdDoc, dw.peso, qw.peso order by 2 desc

|

9.2.3.3 Herramientas

|

Producto |

Lenguaje |

Modelos |

Indexamiento |

API desarrollo |

Licencia |

|

Managing Gigabytes |

C/C++, envoltura Java |

Vectorial |

Propietario |

Ninguno |

Open Source |

|

Xapian |

C/C++ |

Probabilístico |

Propietario |

Limitado |

Open Source |

|

Lucene |

Java |

Vectorial |

Propietario |

Abierto y extendible |

Open Source |

|

MySQL FullText |

C/C++ Java (SMART) |

Vectorial |

Propietario ISAM |

SQL |

Open Source |

|

Egothor |

Java |

Booleano Extendido |

Propietario |

Ninguno |

Open Source |

|

Creación de tabla y utilización de Match mysql> CREATE TABLE articles ( Mostrar los resultados incluyendo la relevancia de cada uno mysql> SELECT id,MATCH (title,body) AGAINST ('Tutorial') FROM articles;

Ejemplo que recupera los resultados y sus scores de similitud. mysql> SELECT id, body, MATCH (title,body) AGAINST Con la versión 4.0.1 se pueden hacer búsquedas a texto completo incluyendo operadores booleanos. mysql> SELECT * FROM articles WHERE MATCH (title,body)

|

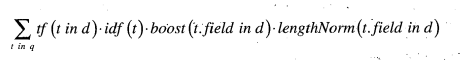

Lucene

Características

- Concurrencia

- Diferentes "ports": Perl, Python, C++, .Net, Ruby

- Scoring

|

|

Diferentes tipos de Fields

public Field(String name, String value, Field.Store store, Field.Index index)

- Create a field by specifying its name, value and how it will be saved in the index. Term vectors will not be stored in the index.

Parameters:

- name - The name of the field

- value - The string to process

- store - Whether value should be stored in the index

Field Summary static Field.Store COMPRESS

Store the original field value in the index in a compressed form.static Field.Store NO

Do not store the field value in the index.static Field.Store YES

Store the original field value in the index. - index - Whether the field should be indexed, and if so, if it should be tokenized before indexing

| Field Summary | |

| static Field.Index | NO Do not index the field value. |

| static Field.Index | NO_NORMS Index the field's value without an Analyzer, and disable the storing of norms. |

| static Field.Index | TOKENIZED Index the field's value so it can be searched. |

| static Field.Index | UN_TOKENIZED Index the field's value without using an Analyzer, so it can be searched. |

Fields en las versiones anteriores (< 2.0):

|

Field method type |

Analyzed |

Indexed |

Stored |

Usage |

| Field.Keyword(String, String) Field.Keyword(String, Date) |

X |

X |

Telephone and Social Security numbers, URLs, personal

names Dates |

|

| Field.Unindexed(String,String) |

X |

Document type (pdf, html, etc), if not used as a search criteria | ||

| Field.Unstored(String, String) |

X |

X |

Document titles and content | |

| Field.Text(String, String) |

X |

X |

X |

Document titles and content |

| Field.Text(String, Reader) |

X |

X |

Document titles and content |

Core Classes

- IndexWriter: crea el índice y agrega documentos a éste

- Directory: la ubicación del índice, se puede tener un FSDirectory o un RAMDirectory, dependiendo si se desea tener dicho índice en disco o en memoria

- Analyzer: proceso que analiza y limpia el texto (stop words, stemming) antes de que sea indexado

- Document: una colección de Fields

- Field: pareja de un nombre y valor, con que sirven para identificar las distintas partes de un documento; estas parejas pueden ser tan simples como "id" y "234" o bien tan complejas como texto completo "contenido" y "Había una vez...."

- IndexSearcher: abre y emplea el índice en read-only para realizar las búsquedas

- Term: unidad básica de búsqueda (son creados por el indexer)

- Query: distintas subclases para crear queries, BooleanQuery, PhraseQuery, RangeQuery, etc.

- TermQuery: un Term asociado a un query el cual puede poseer un nivel de "boost" para darle mayor peso sobre otros términos

- Hits: contenedor de apuntadores hacia los resultados ranqueados de una búsqueda

Ejemplo de programación con Lucene

|

Uso de vectores para encontrar similitudes con Lucene (fragmento cap.5 Lucene in Action)